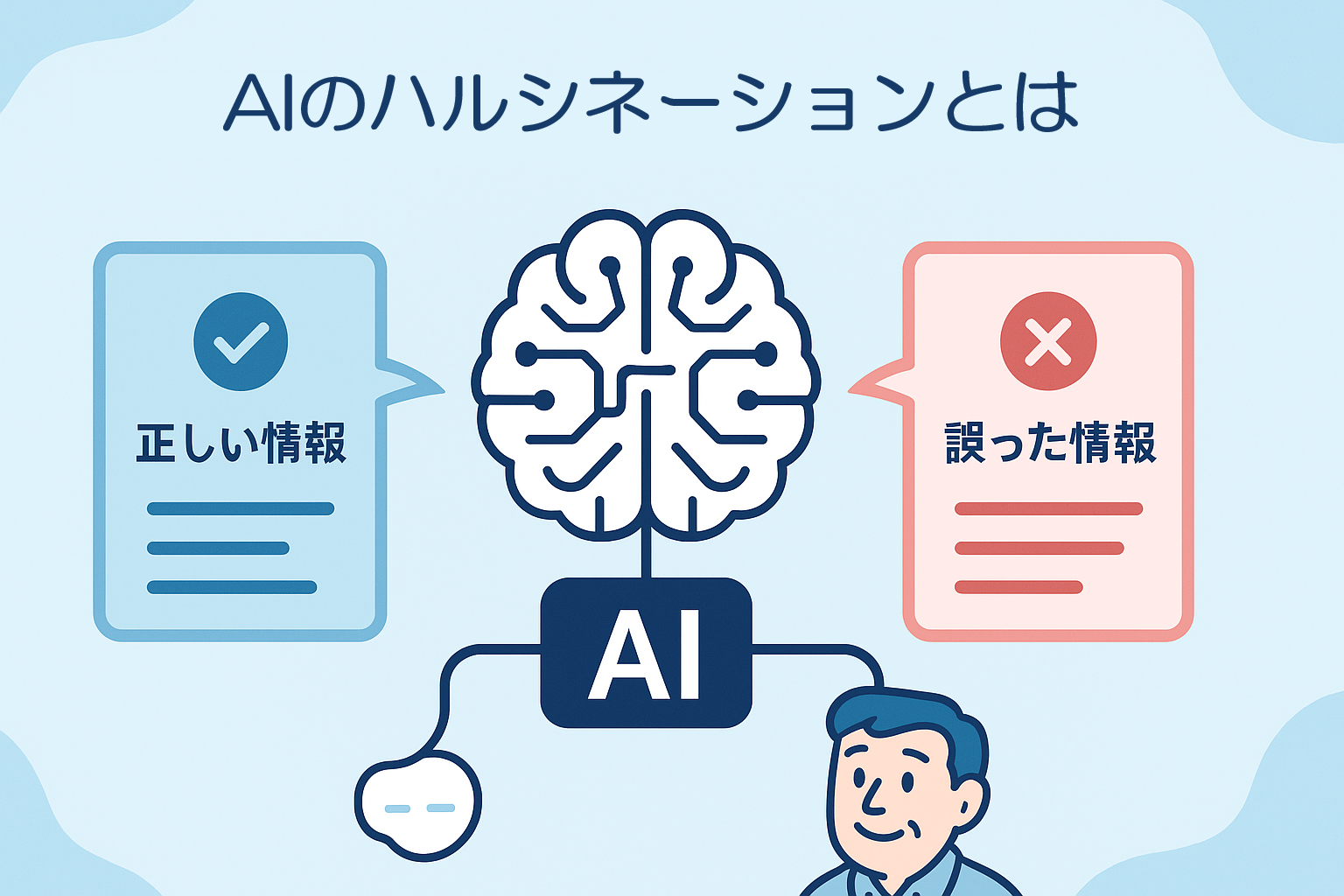

本日は「AIのハルシネーション」についてご紹介します。

結論:AIは“もっともらしく誤る”可能性があります

AIによるテキスト生成が広く普及する中で、重要な注意点として挙げられるのが「ハルシネーション(Hallucination)」と呼ばれる現象です。これは、生成AIが事実とは異なる情報を、まるで正確かのように出力することを指します。特にAIツールのChatGPTのような言語モデルにおいては、正確な知識に基づいているように見える文章でも、その一部が虚偽である可能性があるのです。

それでは、詳しく見ていきましょう。

ハルシネーションとは何か?

「ハルシネーション」という言葉は元々、幻覚という意味で医学分野から来ていますが、AIの文脈では「事実に基づかない内容を生成する現象」として使われます。たとえば、ChatGPTに「ある専門家の見解」や「歴史的な出来事」を質問した場合、実在しない発言や出来事をそれらしく提示することがあるのです。

これは、ChatGPTがインターネット上の大量のテキストを学習している一方で、「事実」と「事実らしく見えるパターン」を区別する能力を持たないことに起因します。

なぜハルシネーションが起きるのか?

以下の3つの理由が考えられます。

1.目的が「正確性」ではなく「自然な言語生成」であるため

生成AIは正確な答えを出すことを目的としているわけではなく、「文脈に合った自然な応答を作ること」に重点を置いています。そのため、言語的には自然でも、内容が誤っているという結果になり得るのです。

2.最新情報や専門的知識の限界

生成AIの知識は2024年までのデータをベースにしており、それ以降の情報やマイナーな情報には対応できない場合があります。結果として、推測や曖昧な情報が回答に混ざることがあります。

3.ユーザーの質問意図に過剰に応えようとする傾向

生成AIは、ユーザーの期待に応えるよう最適化されているため、「答えが存在しない問い」に対しても何らかの答えを出そうとしてしまいます。これは、“知らないなら知らない”とは言いづらい構造とも言えるでしょう。

ハルシネーションとどう向き合うべきか?

実は、この現象を完全に防ぐことは現状の技術では難しいのです。だからこそ、私たちユーザー側のリテラシーが重要になります。具体的には、以下の対応策が有効です。

AIの出力を常に検証する

特に数値や事実に関する情報は、必ず出典を確認しましょう。ChatGPTなどの回答を「一次情報」ではなく、「参考意見」として捉える視点が大切です。

専門性が求められる分野では慎重になる

法律、医療、金融などの分野では、誤った情報が大きなリスクにつながります。専門家のチェックを前提とした運用が望ましいでしょう。

目的に応じた使い方をする

たとえば、ブレインストーミングや文章の草案作成には非常に有効ですが、「正確な事実確認」の手段としては限定的であると認識すべきです。

まとめ:AIを使いこなすのは“人間”です

ChatGPTなどのAIツールは非常に便利で可能性に満ちたツールですが、ハルシネーションという特性を理解していないと、誤情報の拡散や判断ミスにつながる恐れがあります。

私たちが気をつけるべきポイントは、「AIの賢さ」を過信せず、「AIの性質」を理解した上で使うことです。AIと人間、それぞれの強みを補完し合う姿勢が、これからの時代に求められるリテラシーだと考えています。

皆様のAI活用が、より効果的で安全なものになることを願っております。質問やご意見がありましたら、ぜひコメント欄でお知らせください。